OpenAI o1自博弈RL革新推演:重塑AI训练边界

打破常规的视角:自博弈RL的无限可能

在AI发展的浩瀚宇宙中,OpenAI的o1自博弈RL技术犹如一颗璀璨的星辰,照亮了AI训练效率的新航道。传统的RL训练依赖于大量的人工标注数据和复杂的模拟环境,成本高且效果有限。而自博弈RL则另辟蹊径,通过智能体在虚拟环境中自我对弈,不断试错和优化策略,实现智能的自主进化。

现有模式的局限性:数据瓶颈与训练成本

尽管RL在游戏、机器人等领域取得了显著成果,但其高昂的训练成本和漫长的迭代周期仍是制约其广泛应用的关键瓶颈。传统的RL算法需要大量的真实或模拟数据来训练模型,而数据的采集、清洗和标注过程繁琐且耗时。此外,复杂环境中的策略优化往往需要数以百万计的迭代,这对于计算资源和时间的消耗都是巨大的挑战。

跨界融合的启示:从生物进化到AI自博弈

自然界的生物进化为我们提供了宝贵的启示。生物通过长期的自然选择和遗传变异,不断优化自身的生存策略,这一过程无需外部干预,完全依靠内部的竞争和协作机制。借鉴这一思路,自博弈RL通过智能体间的自我对弈,模拟了一种类似生物进化的竞争环境,使得智能体能够在不断试错中自我优化。

OpenAI o1自博弈RL:重塑AI训练的新篇章

创新方法的实践:自博弈与多智能体协作

OpenAI的o1自博弈RL技术,通过构建多智能体协作与竞争的环境,实现了智能体之间的高效互动和策略优化。在这种环境中,每个智能体都试图通过优化自己的策略来最大化自身的收益,而同时又会受到其他智能体策略的影响。这种动态平衡的竞争与协作关系,促使智能体不断学习和进化,从而实现智能的自主提升。

案例分享:Dota 2的AI突破

OpenAI的五子棋AI和Dota 2 AI是o1自博弈RL技术的典型应用。在五子棋AI中,智能体通过自我对弈不断学习和优化策略,最终达到了超越人类顶尖选手的水平。而在Dota 2这一复杂的多人在线战术竞技游戏中,OpenAI的AI团队更是通过构建多智能体协作与竞争的环境,实现了AI在复杂环境下的高效决策和协同作战。这些成功案例不仅展示了o1自博弈RL技术的强大潜力,也为AI训练模式的革新提供了新的思路。

未来创新的可能性:深度学习与自博弈RL的融合

随着深度学习技术的不断发展,将深度学习与自博弈RL相结合,有望实现更加智能和高效的AI训练模式。深度学习能够处理复杂的数据表示和特征提取,而自博弈RL则能够通过自我对弈实现策略的自主优化。两者相结合,将能够大幅提升AI的训练效率和性能表现,为AI的广泛应用开辟更加广阔的前景。

激发创意思维的实践建议与资源推荐

实践建议:构建自博弈RL实验平台

为了深入理解自博弈RL的精髓并激发创意思维,建议读者尝试构建自己的自博弈RL实验平台。通过编写代码和调试模型,亲身体验智能体在自我对弈中的学习和进化过程。这不仅能够加深对自博弈RL原理的理解,还能够激发对AI训练模式创新的思考。

资源推荐:开源框架与学术论文

对于想要深入了解自博弈RL技术的读者,推荐关注一些开源的RL框架和学术论文。这些资源不仅提供了丰富的算法实现和实验数据,还能够为读者提供最新的研究动态和学术见解。通过学习和借鉴这些资源,读者可以更快地掌握自博弈RL的核心技术并开展自己的创新研究。

Q&A:常见疑问解答

Q1:自博弈RL技术是否适用于所有类型的AI任务?

A1:自博弈RL技术更适用于具有竞争和协作特性的AI任务。对于一些简单的、无需复杂策略优化的任务,传统的RL方法或监督学习方法可能更加高效。

Q2:如何评估自博弈RL模型的性能?

A2:评估自博弈RL模型的性能可以通过多种方式进行,包括与人类选手的对弈结果、在特定任务上的完成时间、以及与其他智能体的对战胜率等。此外,还可以通过分析智能体的策略和行为来评估其智能水平和决策能力。

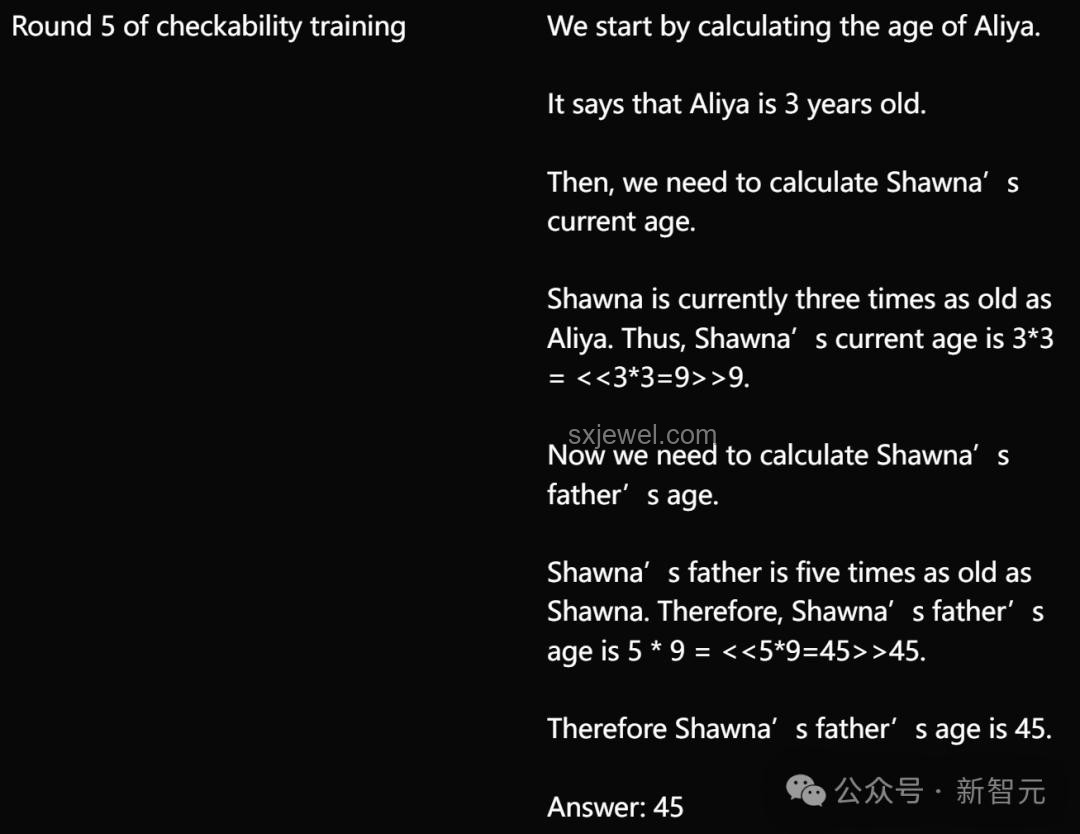

(图片:创意图示)

通过本文对OpenAI o1自博弈RL技术路线的推演,我们不仅看到了AI训练模式革新的无限可能,也感受到了跨界融合思维在推动AI发展中的重要作用。让我们携手并进,共同探索AI的未来之路,为人类的智能生活贡献更多的创新力量!

通过本文对OpenAI o1自博弈RL技术路线的推演,我们不仅看到了AI训练模式革新的无限可能,也感受到了跨界融合思维在推动AI发展中的重要作用。让我们携手并进,共同探索AI的未来之路,为人类的智能生活贡献更多的创新力量!

访客评论 (4 条)

发表您的看法: